O silício mais puro do mundo abre caminho

Pesquisadores da Universidade de Manchester e da Universidade de Melbourne desenvolveram um silício ultrapuro crucial para a criação de computadores quânticos escaláveis, que poderiam potencialmente enfrentar desafios globais, como mudanças climáticas e questões de saúde.

Um grande avanço em

Computação quântica

Realização de computação usando fenômenos da mecânica quântica, como superposição e emaranhamento.

" dados-gt-translate-attributes="[{["atributo":"data-cmtooltip", "formatar":"HTML"]" tabindex="0" role="link">computação quântica foi alcançado com o desenvolvimento de silício ultrapuro, preparando o terreno para a criação de computadores quânticos poderosos e escaláveis.

Há mais de 100 anos, cientistas da Universidade de Manchester mudaram o mundo quando descobriram o núcleo dos átomos, marcando o nascimento da física nuclear.

Avançando até hoje, a história se repete, desta vez na computação quântica.

Com base no mesmo método pioneiro forjado por Ernest Rutherford – “o fundador da física nuclear” – os cientistas da Universidade, em colaboração com a Universidade de Melbourne, na Austrália, produziram uma forma aprimorada e ultrapura de silício que permite a construção de alta dispositivos qubit de desempenho – um componente fundamental necessário para preparar o caminho para computadores quânticos escaláveis.

A descoberta, publicada na revista

Materiais de comunicaçãopoderia definir e impulsionar o futuro da computação quântica.

Avanços na computação quântica

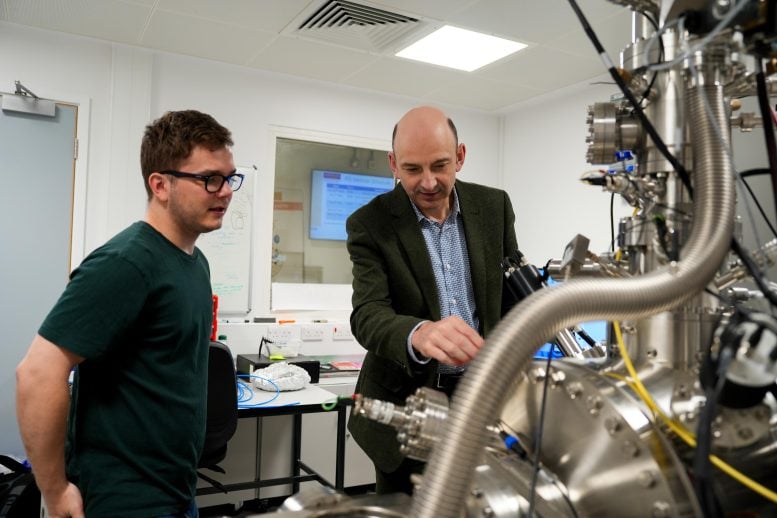

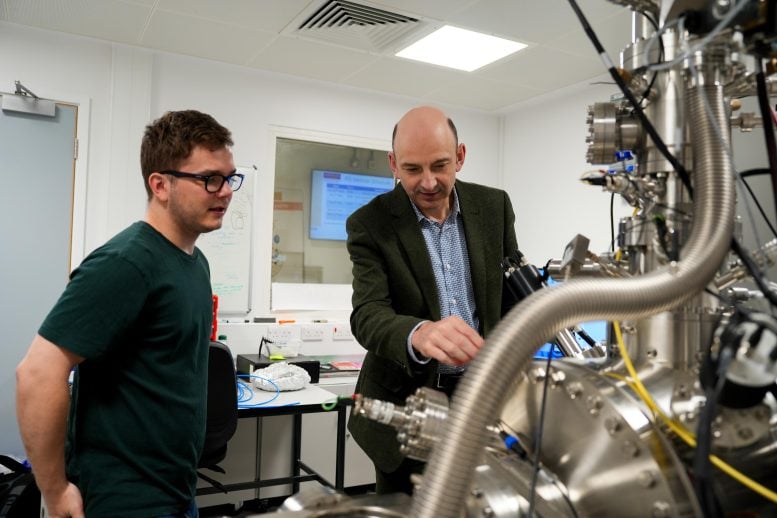

Richard Curry, professor de materiais eletrônicos avançados na Universidade de Manchester, disse:

“O que conseguimos fazer foi criar efetivamente um 'tijolo' crítico necessário para construir um computador quântico baseado em silício. É um passo crucial para tornar viável uma tecnologia que tem o potencial de ser transformadora para a humanidade; uma tecnologia que nos possa dar a capacidade de processar dados numa escala tal que seremos capazes de encontrar soluções para questões complexas, como a resposta ao impacto das alterações climáticas e os desafios dos cuidados de saúde.

Prof Rich Curry (à direita) e Dr. Mason Adshead (à esquerda). Crédito: Universidade de Manchester

“É apropriado que esta conquista esteja alinhada com o 200º aniversário da nossa Universidade, onde Manchester tem estado na vanguarda da inovação científica ao longo deste tempo, incluindo o 'dividir o

átomo

Um átomo é o menor componente de um elemento. É composto de prótons e nêutrons dentro do núcleo e elétrons circulando o núcleo.

" dados-gt-translate-attributes="[{["atributo":"data-cmtooltip", "formatar":"HTML"]" tabindex="0" role="link">atom' descoberta em 1917, depois em 1948 com 'The Baby' – a primeira demonstração na vida real da computação eletrônica com programas armazenados, agora com este passo em direção à computação quântica.”

Superando Desafios Quânticos

Um dos maiores desafios no desenvolvimento de computadores quânticos é que os qubits – os blocos de construção da computação quântica – são altamente sensíveis e requerem um ambiente estável para manter a informação que contêm. Mesmo pequenas mudanças no ambiente, incluindo flutuações de temperatura, podem causar erros no computador.

Outra questão é a sua escala, tanto o seu tamanho físico como o seu poder de processamento. Dez qubits têm o mesmo poder de processamento que 1.024 bits em um computador normal e podem ocupar potencialmente um volume muito menor. Os cientistas acreditam que um computador quântico com pleno desempenho precisa de cerca de um milhão de qubits, o que fornece uma capacidade inviável por qualquer computador clássico.

O papel do silício na computação quântica

O silício é o material de base da computação clássica devido às suas propriedades semicondutoras e os pesquisadores acreditam que pode ser a resposta para computadores quânticos escaláveis. Os cientistas passaram os últimos 60 anos aprendendo como projetar o silício para fazê-lo funcionar da melhor forma possível, mas na computação quântica ela tem seus desafios.

O silício natural é composto de três átomos de massas diferentes (chamados isótopos) - silício 28, 29 e 30. No entanto, o Si-29, que representa cerca de 5% do silício, causa um efeito de 'flopping nuclear', fazendo com que o qubit perder informações.

Num avanço na Universidade de Manchester, os cientistas descobriram uma maneira de projetar silício para remover os átomos de silício 29 e 30, tornando-o o material perfeito para fazer computadores quânticos em escala e com alta eficiência.

precisão

Quão próximo o valor medido está em conformidade com o valor correto.

" dados-gt-translate-attributes="[{["atributo":"data-cmtooltip", "formatar":"HTML"]" tabindex="0" role="link">precisão.

O resultado – o silício mais puro do mundo – fornece um caminho para a criação de um milhão de qubits, que podem ser fabricados no tamanho de uma cabeça de alfinete.

Ravi Acharya, pesquisador PhD que realizou trabalho experimental no projeto, explicou: “A grande vantagem da computação quântica de silício é que as mesmas técnicas usadas para fabricar os chips eletrônicos

- atualmente dentro de um computador comum que consiste em bilhões de transistores

- pode ser usado para criar qubits para dispositivos quânticos baseados em silício. A capacidade de criar qubits de silício de alta qualidade foi em parte limitada até o momento pela pureza do material inicial de silício utilizado. A pureza inovadora que mostramos aqui resolve este problema.”

A nova capacidade oferece um roteiro para dispositivos quânticos escaláveis com desempenho e capacidades incomparáveis e promete transformar tecnologias de maneiras difíceis de imaginar.

O co-supervisor do projeto, professor David Jamieson, da Universidade de Melbourne, disse: “Nossa técnica abre o caminho para computadores quânticos confiáveis que prometem mudanças radicais em toda a sociedade, inclusive em inteligência artificial, dados e comunicações seguras, design de vacinas e medicamentos, e uso de energia, logística e fabricação.

“Agora que podemos produzir silício-28 extremamente puro, nosso próximo passo será demonstrar que podemos sustentar a coerência quântica para muitos qubits simultaneamente. Um computador quântico confiável com apenas 30 qubits excederia o poder dos supercomputadores atuais para algumas aplicações”,

Compreendendo a computação quântica

Todos os computadores operam usando elétrons. Além de terem carga negativa, os elétrons têm outra propriedade conhecida como “spin”, que é frequentemente comparada a um pião.

A rotação combinada dos elétrons dentro da memória de um computador pode criar um campo magnético. A direção deste campo magnético pode ser usada para criar um código onde uma direção é chamada de '0' e a outra direção é chamada de '1'. Isso nos permite usar um sistema numérico que usa apenas 0 e 1 para dar instruções ao computador. Cada 0 ou 1 é chamado de bit.

Num computador quântico, em vez do efeito combinado do spin de muitos milhões de eletrões, podemos usar o spin de eletrões individuais, passando do trabalho no mundo “clássico” para o mundo “quântico”; do uso de 'bits' para 'qubits'.

Enquanto os computadores clássicos fazem um cálculo após o outro, os computadores quânticos podem fazer todos os cálculos ao mesmo tempo, permitindo-lhes processar grandes quantidades de informações e realizar cálculos muito complexos a uma velocidade incomparável.

Embora ainda se encontrem nas fases iniciais da computação quântica, uma vez totalmente desenvolvidos, os computadores quânticos serão utilizados para resolver problemas complexos do mundo real, como a concepção de medicamentos, e fornecer previsões meteorológicas mais precisas – cálculos demasiado difíceis para os supercomputadores actuais.

Referência: “Altamente

28Silício enriquecido com Si por implantação de feixe de íons focado localizado” por Ravi Acharya, Maddison Coke, Mason Adshead, Kexue Li, Barat Achinuq, Rongsheng Cai, A. Baset Gholizadeh, Janet Jacobs, Jessica L. Boland, Sarah J. Haigh, Katie L. Moore, David N. Jamieson e Richard J. Curry, 7 de maio de 2024,

Materiais de comunicação.

DOI: 10.1038/s43246-024-00498-0

Este trabalho foi apoiado pelo Conselho de Pesquisa em Engenharia e Ciências Físicas do Reino Unido (EPSRC), especificamente pelo Programa Grant 'Engenharia de Materiais Avançados em Nanoescala liderado pelo Prof. A colaboração do Professor Jamieson com a Universidade de Manchester é apoiada pela Royal Society Wolfson Visiting Fellowship e pelo Australian Research Council. Ravi Acharya é estudante de doutorado conjunto da Universidade de Manchester e da Universidade de Melbourne, apoiado por uma bolsa Cookson.

O silício mais puro do mundo abre caminho

https://w3b.com.br/o-silicio-mais-puro-do-mundo-abre-caminho-para-computadores-quanticos-de-ultima-geracao/?feed_id=5950&_unique_id=66590de232278

[caption id="attachment_87426" align="alignnone" width="1920"]

[caption id="attachment_87426" align="alignnone" width="1920"] xr:d:DAFgxpUo8zc:2993,j:5419376384117858530,t:24022819[/caption]

xr:d:DAFgxpUo8zc:2993,j:5419376384117858530,t:24022819[/caption]